安装Ollama for Intel

Ollama 是一个强大的工具,用于在本地运行和优化大型语言模型(LLM)。随着Intel Arc显卡的发布,许多开发者希望利用其强大的计算能力来加速Ollama的运行。本文将详细介绍如何在Intel Arc显卡环境中安装和配置Ollama,并介绍Ollama相关的命令。

目录

简述

Ollama 是一个强大的工具,用于在本地运行和优化大型语言模型(LLM)。随着Intel Arc显卡的发布,许多开发者希望利用其强大的计算能力来加速Ollama的运行。本文将详细介绍如何在Intel Arc显卡环境中安装和配置Ollama,并介绍Ollama相关的命令。

1. 环境准备

1.1 硬件要求

-

显卡:Intel Arc系列显卡。

-

操作系统:Windows 10/11 。

-

驱动:确保已安装最新版本的Intel显卡驱动。

1.2 软件依赖

-

Python 3.8+:Ollama依赖Python环境。

2. 安装步骤

检查驱动程序版本,尽量安装新版本驱动。

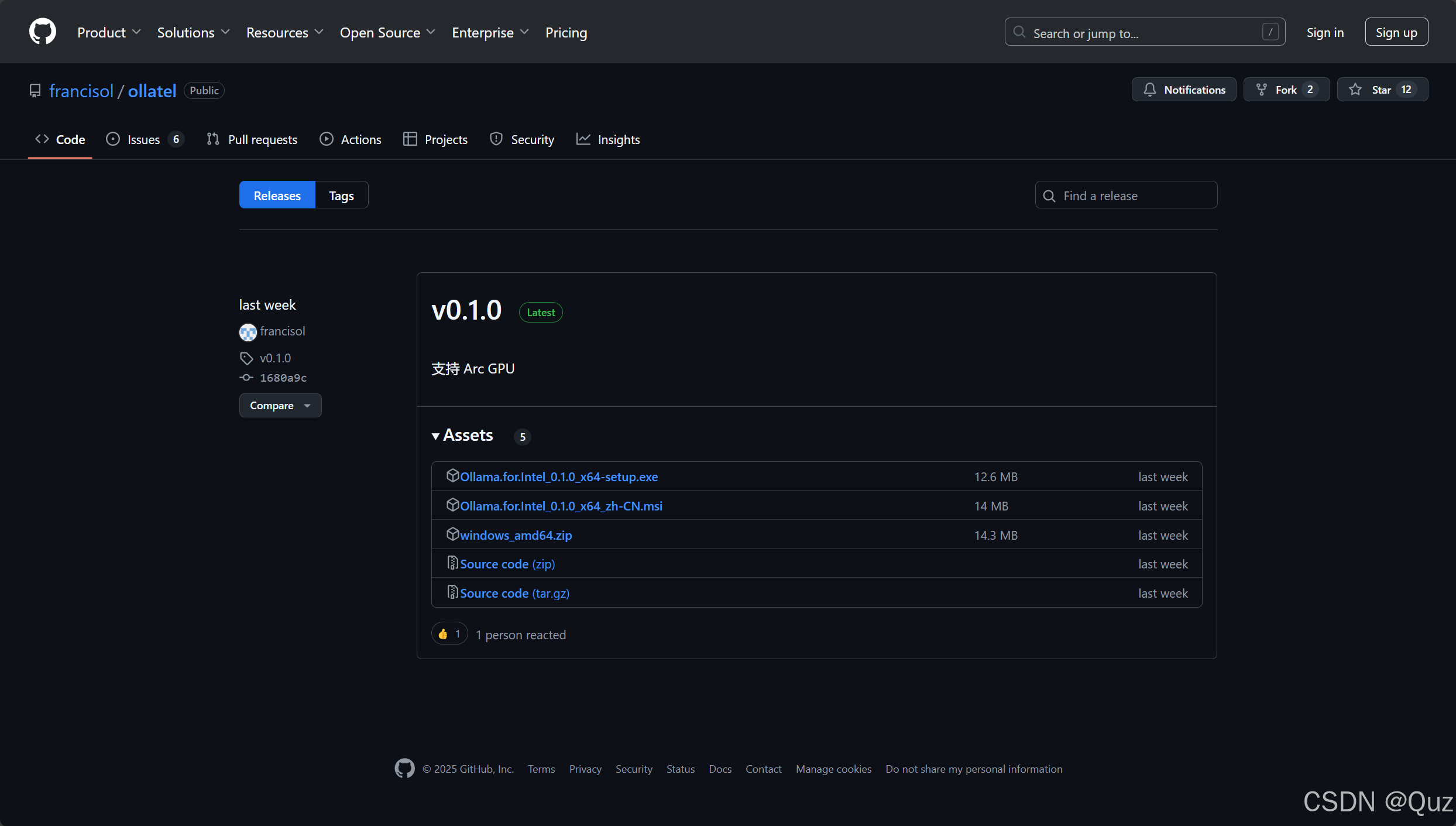

下载Ollama:Releases · francisol/ollatel

或者通过网盘下载:

通过网盘分享的文件:Ollama.for.Intel_0.1.0_x64-setup.exe

链接: https://pan.baidu.com/s/1lkH-xMYxxmBJlW6b9FXcuw?pwd=csdn 提取码: csdn

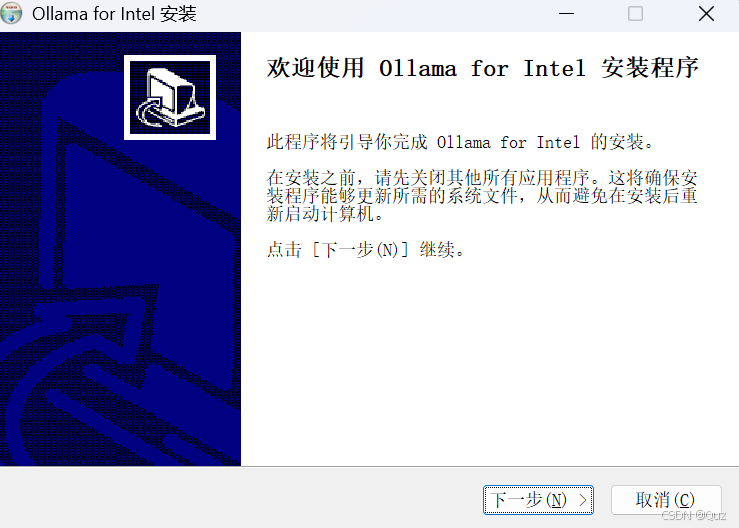

安装Ollama for Intel:

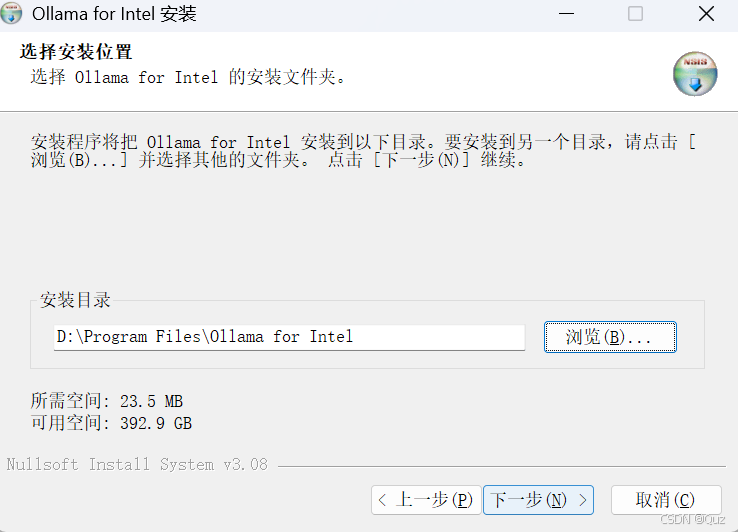

选择路径:

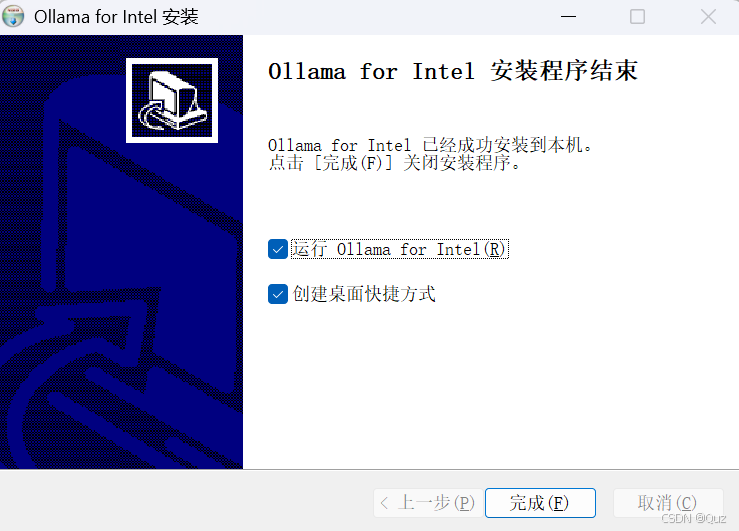

安装完成:

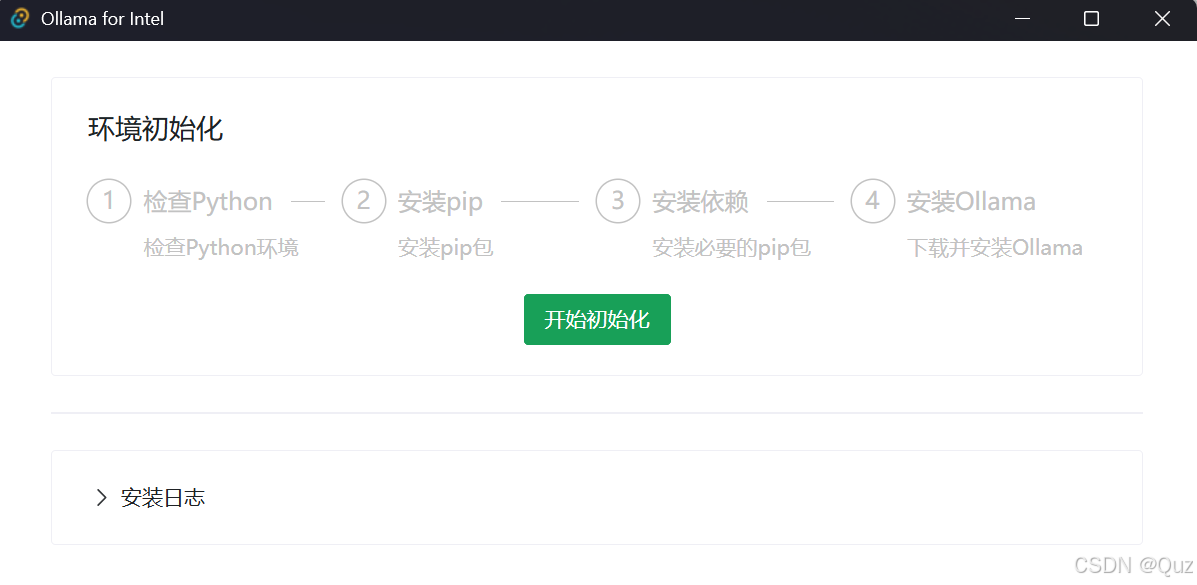

运行Ollama for Intel:

点击初始化。

点击初始化。

安装pip:(自动)

安装依赖:(自动)

环境设置成功后跳转到 Ollama 控制页面,可以在此处启动或关闭 Ollama 服务。如果需要使用 ollama 命令,请点击打开 CMD 或打开 powershell 按钮。

3. Ollama命令

以下是 Ollama 的命令列表及其功能说明,以表格形式呈现:

| 命令 | 功能描述 | 示例用法 | 参数说明 |

|---|---|---|---|

| serve | 启动 Ollama 服务 | ollama serve | 无参数,直接启动服务 |

| create | 根据 Modelfile 创建自定义模型 | ollama create mymodel -f Modelfile | -f 指定 Modelfile 路径 |

| show | 显示模型详细信息(如配置、版本等) | ollama show mymodel | 需提供模型名称 |

| run | 运行指定模型 | ollama run mymodel | 模型名称必填,可附加交互式参数(如输入文本) |

| stop | 停止正在运行的模型 | ollama stop mymodel | 需提供模型名称 |

| pull | 从远程仓库拉取模型 | ollama pull library/mymodel:latest | 需提供模型名称及版本(格式:仓库名/模型名:标签) |

| push | 推送本地模型到远程仓库 | ollama push mymodel:latest | 需提供模型名称及版本标签 |

| list | 列出本地已安装的模型 | ollama list | 无参数,直接列出所有模型 |

| ps | 列出当前正在运行的模型 | ollama ps | 无参数,显示运行状态 |

| cp | 复制模型(生成新副本) | ollama cp mymodel mymodel_copy | 需提供源模型名称和目标名称 |

| rm | 删除本地模型 | ollama rm mymodel | 需提供模型名称 |

| help | 查看命令帮助信息 | ollama help create | 可附加子命令名称(如 help create) |

全局标志(Flags)

| 标志 | 功能描述 | 示例用法 |

|---|---|---|

| -h, --help | 显示命令帮助信息 | ollama --help |

| -v, --version | 显示 Ollama 版本信息 | ollama --version |

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)