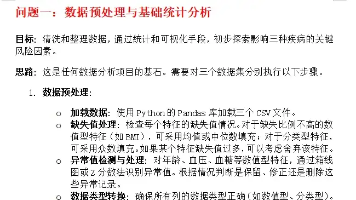

Spring AI 本地Ollama

本文介绍了Ollama大模型的本地部署及与Spring AI的集成方案。主要内容包括:Ollama在Linux/WSL2等环境下的安装方法,DeepSeek-R1等模型的下载与运行;Spring AI通过引入Ollama依赖实现本地集成;性能优化方案如硬件加速、轻量化模型选择;常见问题处理如资源不足、CUDA内存错误等。该方案帮助开发者快速构建本地化AI应用,平衡灵活性与性能需求。

目录

Spring AI 介绍

Spring AI 组件介绍

Spring AI 结构化输出

Srping AI 多模态

Spring AI 本地Ollama

Spring AI 源码

Spring AI Advisor机制

Spring AI Tool Calling

Spring AI MCP

Spring AI RAG

Spring AI Agent

相关文档

AI Ollama 下载和安装

大模型 ollama命令详解大全

大模型deepseek-r1 本地ollama部署详解

大模型Ollama RestAPI 详解

Ollama自定义模型

简单样例

Spring AI 与 Ollama 的本地集成方案为开发者提供了便捷的大模型应用开发路径,以下是关键实现步骤和技术要点:

一、Ollama 本地部署

1. 安装与启动

- Linux/WSL2 环境:通过脚本一键安装 curl -fsSL https://ollama.ai/install.sh | sh3

- Windows/macOS:下载官方客户端安装

- 启动后可通过命令行验证服务状态

- 模型下载

- 支持多尺寸模型按需选择(如 DeepSeek-R1 的 1.5B/7B/70B 等版本):

ollama run deepseek-r1:7b

```:ml-citation{ref="3,7" data="citationList"}

- 新增多模态引擎优化了图像处理与内存管理

二、Spring AI 集成配置

1. 依赖引入

<dependency>

<groupId>io.springboot.ai</groupId>

<artifactId>spring-ai-ollama</artifactId>

<version>1.0.3</version>

</dependency>

```:ml-citation{ref="4,6" data="citationList"}

2. 基础代码示例

- 配置 Ollama 连接参数(需与本地服务端口一致)

- 通过 OllamaChatClient 调用模型 API

三、优化与扩展

- 性能提升:结合 NVIDIA/Intel 等硬件厂商的元数据检测优化推理速度

- 国产模型支持:DeepSeek LLM 等轻量化模型适合低成本开发

- 未来方向:Ollama 计划支持更长上下文和流式响应

四、常见问题

- 资源不足:可选用小参数模型(如 1.5B)适应低配环境

- CUDA 内存错误:检查 WSL2 或本地 GPU 驱动配置

通过上述方案,开发者可快速构建本地化 AI 应用,兼顾灵活性与性能。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)