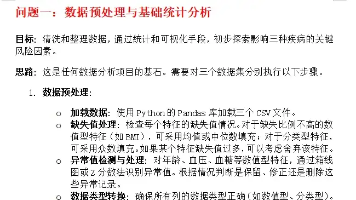

transformer_point-wise是什么意思

因此,在Transformer中,“stacked self-attention and point-wise”意味着。具体来说,在Transformer的编码器和解码器中,除了自注意力(self-attention)层之外,“point-wise” 通常指的是一种操作方式,,后者会考虑所有位置的信息来计算每个位置的输出。在Transformer模型的上下文中,会对这些向量中的每一个分别应用。逐点

在Transformer模型的上下文中,

“point-wise” 通常指的是一种操作方式,

它逐点(或逐个位置)地处理输入数据。

这与“self-attention”机制形成对比,

后者会考虑输入序列中所有位置的信息来计算每个位置的表示。

具体来说,在Transformer的编码器和解码器中,

除了自注意力(self-attention)层之外,

通常还会有一个或多个前馈神经网络(Feed-Forward Neural Network, FFN)层。

这些前馈神经网络层就是以point-wise的方式工作的。

它们对每个位置(或称为“点”)的输入向量独立地应用相同的线性变换和非线性激活函数。

换句话说,

如果我们将输入序列表示为一系列向量(每个向量对应序列中的一个位置),

则point-wise操作会对这些向量中的每一个分别应用相同的操作(如线性变换和ReLU激活)。

这与全局操作(如自注意力)不同,后者会考虑所有位置的信息来计算每个位置的输出。

因此,在Transformer中,“stacked self-attention and point-wise”意味着

模型首先通过堆叠的自注意力层来捕捉输入序列中的全局依赖关系,

然后通过逐点的前馈神经网络层来进一步处理这些表示,以提取更高层次的特征。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)